Un ranking que mezcla datos y preferencias humanas

Antes de entrar en materia debemos conocer lo que mide esta clasificación. El Chatbot Arena+ combina el sistema Elo Arena, basado en más de 5 millones de votos humanos con métricas estandarizadas como AAII v3, MMLU-Pro y ARC-AGI v2. Es decir, ofrece una fotografía completa de rendimiento con precisión técnica, capacidad de razonamiento y valoración subjetiva de los usuarios.

- AAII v3 (Evaluación Avanzada de Inteligencia Artificial v3): Un benchmark que analiza el razonamiento de los diferentes modelos en 10 tareas técnicas complejas.

- MMLU-Pro (Massive Multitask Language Understanding – Professional): Una versión avanzada que mide la comprensión del lenguaje en múltiples disciplinas, todo a nivel universitario.

- ARC-AGI v2 (Abstraction and Reasoning Challenge for AGI v2): Evalúa el razonamiento abstracto mediante rompecabezas visuales. Los humanos alcanzan unos resultados cercanos al 100% mientras que los modelos de IA actualen se mueven entre un 10% y un 20%.

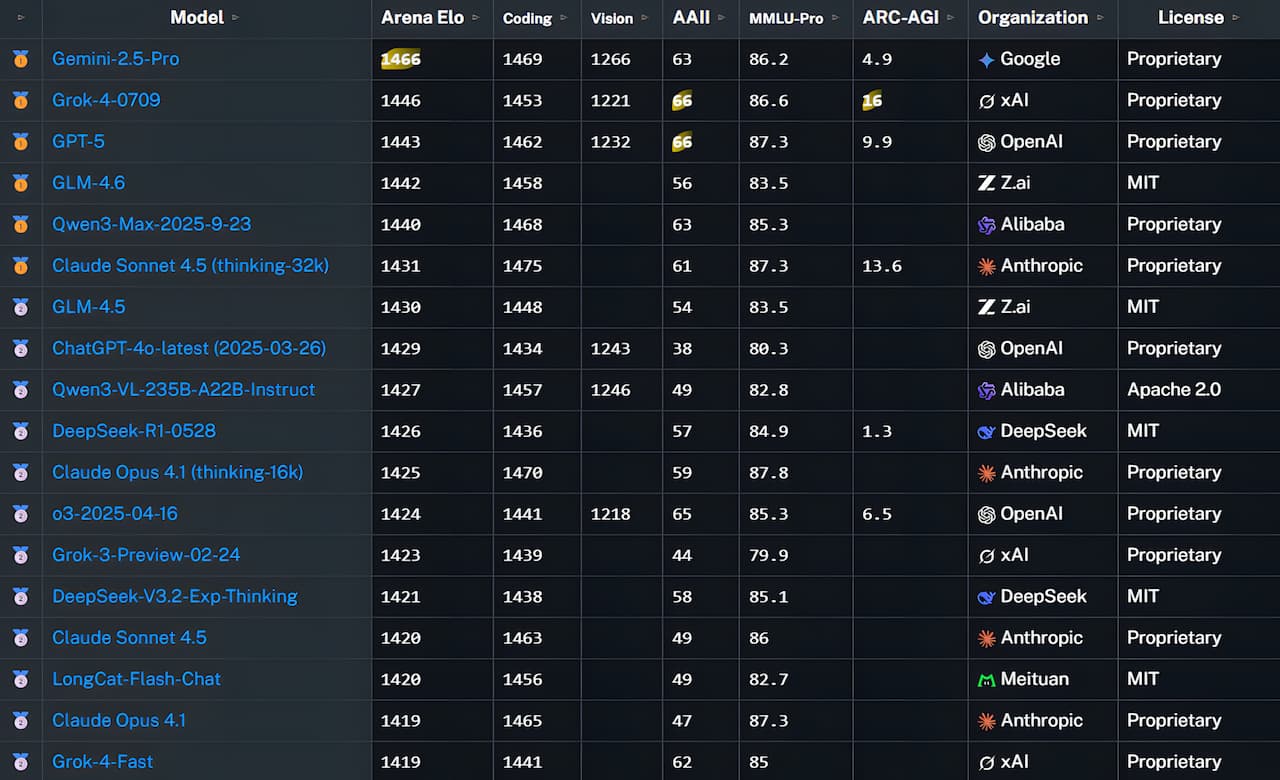

Top 5 mundial de modelos LLM — octubre 2025

| Posición | Modelo | Elo global | Codificación | Visión | AAII v3 | MMLU-Pro (%) | ARC-AGI v2 |

|---|---|---|---|---|---|---|---|

| 1 | Gemini 2.5 Pro (Google) | 1466 | 1469 | 1266 | 63 | 86.2 | 4.9 |

| 2 | Grok-4-0709 (xAI) | 1446 | 1453 | 1221 | 61 | 85.4 | 4.6 |

| 3 | GPT-5 (OpenAI) | 1443 | 1462 | 1248 | 62 | 85.8 | 4.8 |

| 4 | Claude Sonnet 4.5 (Anthropic) | 1431 | 1441 | 1212 | 60 | 84.9 | 4.5 |

| 5 | Qwen 2.5 Max (Alibaba Cloud) | 1409 | 1433 | 1207 | 58 | 83.7 | 4.3 |

La batalla entre gigantes: diferencias mínimas y estrategias distintas

Lo que se aprecia a simple vista según los datos de OpenLM.ai es una gran igualdad entre grandes modelos de lenguaje. Gemini 2.5 Pro destaca por su capacidad multimodal, además de por su equilibrio entre razonamiento lógico y generación de código.

En el caso de Chat GPT-5, tenemos un buen rendimiento en programación y resolución de problemas. No obstante, su puntuación Elo global cae por la preferencia de respuestas más “humanas” por parte de los usuarios. Recordemos la polémica llegada de esta nueva versión y como los usuarios forzaron a OpenAI a permitir volver a elegir modelos antiguos como 4o.

Claude 4.5 de Anthropic ha reforzado su enfoque en seguridad y ética, siendo uno de los modelos más fiables. Por su parte Grok-4 gana terreno en contexto conversacional. A nivel personal, coincido bastante con esta clasificación según mis hábitos, pero sí es cierto que le daría algo más de puntuación a la IA de Elon Musk en codificación.

El auge de la IA China

Aunque nos hemos centrado en ver a los modelos más conocidos por todos como Gemini 2.5 Pro de Google, GPT-5 (OpenAI), Claude Sonnet 4.5 (Anthropic) y Grok-4-0709 (xAI), lo cierto es que el ranking esconde muchas cosas que analizar. Seguro que a muchos les sorprende ver en cuarta y quinta posición, por encima de Claude, a dos inteligencias artificiales chinas.

Por un lado, tenemos a GLM-4.6, un modelo de lenguaje desarrollado por Zhipu AI que amplía la ventana de contexto hasta unos 200 000 tokens. Por otro lado, encontramos a Qwen3-Max-2025-9-23, el modelo tope de gama de Alibaba Cloud, con más de un billón de parámetros. Ambos modelos se acercan muchísimo a Gemini-2.5-Pro, Grok-4-0709 o GPT-5. No obstante, la gran diferencia es que son de código abierto.

Qué significa este resultado para la industria

La primera posición de Gemini 2.5 Pro no es definitiva, ni pude permitir a los de Google dormirse en los laureles. Una diferencia de menos de 30 puntos Elo entre los cuatro primeros muestran una madurez bastante interesante de los modelos de lenguaje. Tampoco podemos dejar de fijarnos en las inteligencias artificiales que vienen de China y que están pisando los talones.

Ahora mismo, los cuatro gigantes de la IA mundial pasan por este punto:

- Google lidera la integración multimodal con texto, imagen y audio.

- OpenAI mantiene el liderazgo en tareas técnicas y compatibilidad API.

- Anthropic apuesta por la seguridad, rigor y transparencia.

- xAI apuesta por un tono más emocional del lenguaje.

Para el usuario son todo buenas noticias. Cada vez más y mejor competencia que nos permite ir probando cada uno de los modelos hasta encontrar el que mejor se ajusta a nuestras necesidades. Incluso, podemos optar por tener varios al mismo tiempo, dedicando cada uno de ellos a un tipo de tareas.

¿Qué modelo de IA usar según la tarea?

| Modelo | Fortaleza Principal | Benchmark Clave | Puntuación Destacada | Ideal para... |

|---|---|---|---|---|

| Gemini 2.5 Pro | Análisis Multimodal (texto + imagen) | MMMU | 79.6% | Analizar documentos con gráficos, auditorías visuales, investigación científica. |

| GPT-5 | Programación Algorítmica | HumanEval | 92.7% | Desarrolladores, resolución de problemas de código, integración en ecosistema Microsoft. |

| Claude 4.5 | Seguridad y Codificación Real | SWE-bench | 72.5% | Proyectos empresariales, mantenimiento de código, entornos con altos requisitos de seguridad. |

| Grok-4 | Contexto Conversacional | DialogQA | 84.3% | Atención al cliente avanzada, análisis de diálogos largos, coherencia narrativa. |

Conclusión

Según los analistas de OpenLM.ai, “la era del modelo dominante ha terminado; ahora la clave es la adaptabilidad y la integración en ecosistemas de uso real”. Esto implica que se debe buscar otros caminos para convencer a los usuarios y seguir marcando el puso del mercado de la inteligencia artificial.

Gemini 2.5 Pro, GPT-5, Claude 4.5 y Grok-4 ya no se separan por potencia bruta, sino que lo hacen por sutiles diferencias de integración, API y filosofía de diseño. La próxima actualización del ranking, prevista para enero de 2026, volverá a darnos una imagen fiel de las nuevas versiones y de los modelos abiertos que están despegando.

Fuentes consultadas

OpenLM.ai — Chatbot Arena+ (2025)

Google DeepMind — Blog oficial de Gemini 2.5 Pro

Anthropic — Actualización Claude Sonnet 4.5

xAI — Presentación Grok-4-0709

OpenAI — Notas técnicas GPT-5

Fuente: adslzone